21世纪经济报道记者肖潇 北京报道沈阳配资平台

2025年,被称为“智能体元年”。这是AI发展路径上的一次范式突变:从“我说AI答”到“我说AI做”,从对话生成跃迁到自动执行,智能体正成为最重要的商业化锚点和下一代人机交互范式。

但越接近落地,风险也越有实感。越能干的智能体,越可能越权、越界,甚至失控。

结合调查问卷和行业访谈,本次《智能体体检报告》从最新发展状况、合规认知度、合规实际案例三个角度,试图回答清楚一个关键问题:智能体狂奔之时,安全合规是否就绪了?

本篇观点速览

安全重要,但不着急。67.4%的业内受访者认为智能体的安全合规问题“非常重要”,但优先级排不进TOP 3。出错与泄露。70%以上的受访者最担心AI幻觉与错误决策、数据泄露问题。信息差。大部分使用方并不实际掌握/不清楚智能体有哪些权限、能访问哪些数据(58%)。尚未出现大型安全合规事故?60%的受访者明确否认公司曾出现过智能体安全合规事件,另有40%的人表示不方便透露情况。随着智能体的产业生态和应用场景逐渐清晰,担忧的声量随之而来:一边认为一旦智能体出现安全事故,后果难以控制,急需设置防护栏;另一边认为,智能体的当务之急是发展技术,对安全的过度讨论会阻碍创新。

当下哪一方声音占主流?不同产业角色是如何考虑这一问题的?行业是否存在一些共识?我们结合访谈和问卷调查,试图找到一条认知水位线。

需要说明的是,虽然2025年被认为是“AI 智能体元年”,但智能体尚未像通用大语言模型一样在各行各业被广泛使用。我们收集的问卷来自已经实际落地的、行业核心的国内智能体玩家,涵盖互联网大厂、手机厂商、头部AI创业公司。结合深入访谈的情况,虽然为小样本量调查(n=43),但一定程度上能反映核心情况。

问卷开始时,受访者需要先选择自己的基础信息,角色分为四类:智能体研发公司(提供核心模型/产品/平台),智能体使用公司,智能体合作公司(提供API/插件/基础设施),以及独立研究团队或开发者。

问卷结果显示,受访者中研发厂商、使用方、独立研究团队或开发者数量平均(33%;28%;23%),服务合作者较少(16%)。大部分受访者来自技术团队(67%),小部分来自产品运营团队(30%)。

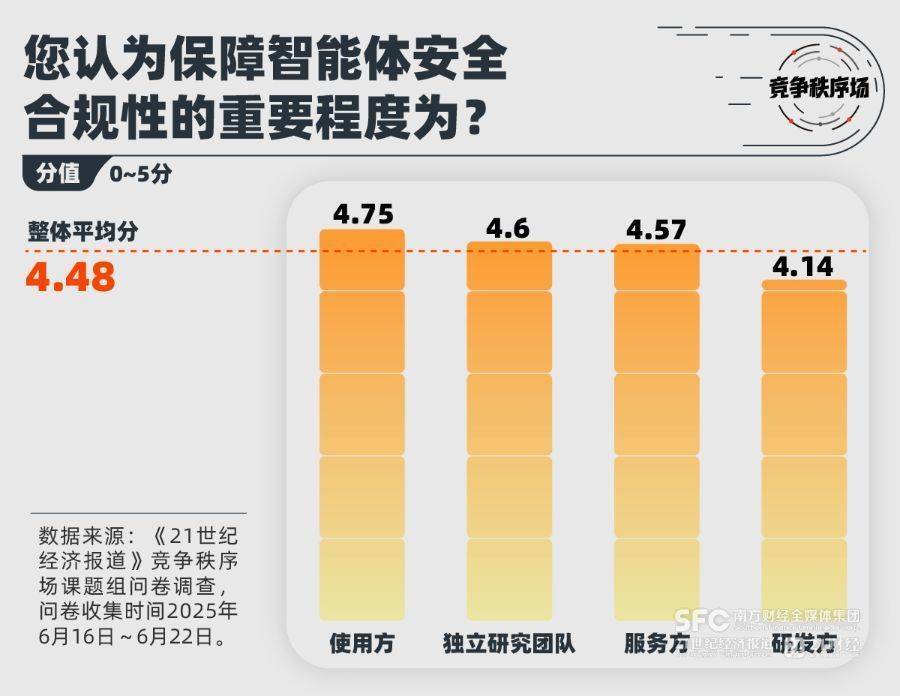

安全合规“重要但不着急”67.4%的受访者一致认为智能体的安全合规问题“非常重要”(5分;满分为5分),整体平均分为4.48分。从不同角色来看,最在意保障安全合规问题的是智能体使用方。

智能体安全合规是否得到了行业的足够关注,没有一个观点得到超过半数的共同认可。最多的看法是行业有所重视,但整体投入与响应不足(48.8%);但也有34.9%的受访者认为行业整体缺乏有效关注,这尤其是研发方中最主流观点。只有一小部分人(16.3%)认为行业已经高度重视,甚至过度重视了。

在受访者中达成了一致的是,安全合规并非智能体最需优先解决的问题。当务之急的TOP 3 问题分别是:智能体执行任务稳定性和完成质量(67.4%)、落地场景探索和产品化(60.5%)、基础模型能力增强(51.2%)。

在这三个问题上,不同角色眼中的优先级不同。研发者和使用者认为最需要解决的问题是“智能体执行任务稳定性和完成质量”,而服务方和独立研究团队更需要“落地场景探索和产品化”。

这也说明尽管行业普遍认为安全问题“非常重要”,但面对技术发展,优先级不在TOP 3。多位访谈者提到,技术发展与安全合规之间一直存在张力,比如公司业务与技术部门想往前推进产品,法务合规团队则担忧安全风险,双方往往需要为共识反复论证;又比如资本市场、厂商会反复强调技术进展,重视产品进度,安全从业者则会屡屡站出来强调治理的重要性。

最先在端侧落地的手机智能体经历了这样的讨论,“一句话点咖啡”等功能成为2024年各家手机厂商抛出的卖点,但是其利用了一项高敏感权限——无障碍权限,存在风险敞口,此前App端无障碍权限滥用就衍生出了一条黑灰产业链。随着包括《竞争秩序场》课题组的系列报道,业内开始广泛讨论无障碍权限的边界。

这与生成式AI刚刚出现时,行业对“科林格里奇困境”的讨论类似。英国技术哲学家大卫·科林格里奇在《技术的社会控制》中提出了这一著名的困境,它指出,在新技术的早期阶段,人们往往难以预测其长期的社会风险;但当这些影响显现出来时,技术往往已经深入社会结构,可能变得覆水难收。

AI治理是一场与时间的博弈,时机的选择决定了治理的可行性与成本。“科林格里奇困境”对智能体的启示可能在于,人们需要在技术早期阶段进行前瞻性评估,并讨论出合适的介入时机。

幻觉和数据泄露是最受关注的问题AI幻觉与错误决策(72%)、数据泄露(72%)、有害内容输出(53.5%) 是行业最普遍关心的三个安全合规问题。

更专业的越狱攻击、身份与权限控制、工具安全和竞争秩序问题,相对获得较少关注。值得一提的是,没有受访者一个安全合规问题都没关注过。

如果出现了安全合规事件,行业最担心的后果是用户数据泄露(81.4%)以及非授权操作带来业务损失(53.49%)。也有一部分人担心被监管调查或处罚(44.19%)。

不同产业角色担心的后果完全不同,几乎所有智能体使用方和服务方都担心用户数据泄露,占比可以达到90%左右,较少有人担心监管调查(40%左右)。而研发方最担心的便是监管调查(72%),其次才是业务损失或用户数据泄露(64%)。

这一定程度上也可以说明,在智能体研发方心中,目前在监管面前承担主要责任的是己方。

一位互联网公司法务谈到,智能体产品或平台的《服务协议》需要列清有哪些智能体、哪项功能调用哪一大模型、如何收集用户数据和信息,是否存储数据及存储期限等。有些智能体可能涉及调用多个底座大模型和工具,在这种情况下,她认为通常由智能体向用户兜底,“不然数据最终去向可能就乱了。”

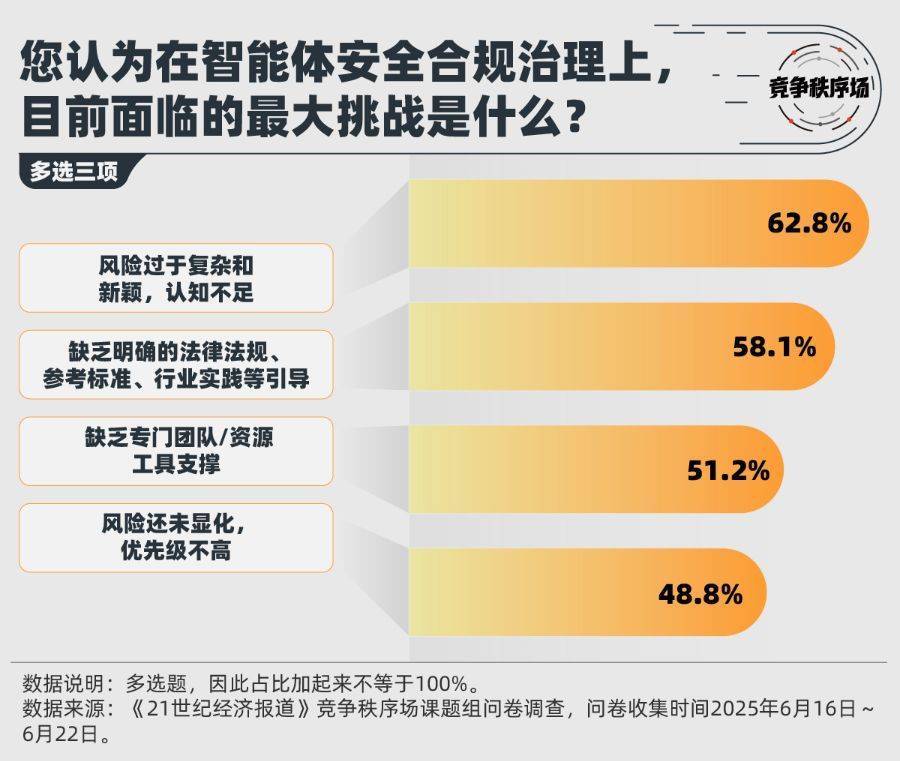

并非问题未显化,而是问题太“新颖”大部分人认为,智能体风险过于复杂和新颖(62.8%)是当前治理智能体治理的最大挑战。而不到一半的人认为智能体风险还未显化、优先级不高是一个挑战(48.8%)。

已出现过的案例能侧面说明这一点。通过访谈了解到,行业现在还没有出现过真实发生的、大范围的安全合规事故。而在一些小型的安全合规事件上,公司出于业务考虑,未必愿意公开讨论。

我们的调查结果显示,60%的受访者明确否认公司曾出现过智能体安全合规事件,另有40%的人表示不方便透露情况,这些情况主要来自使用方和独立团队。

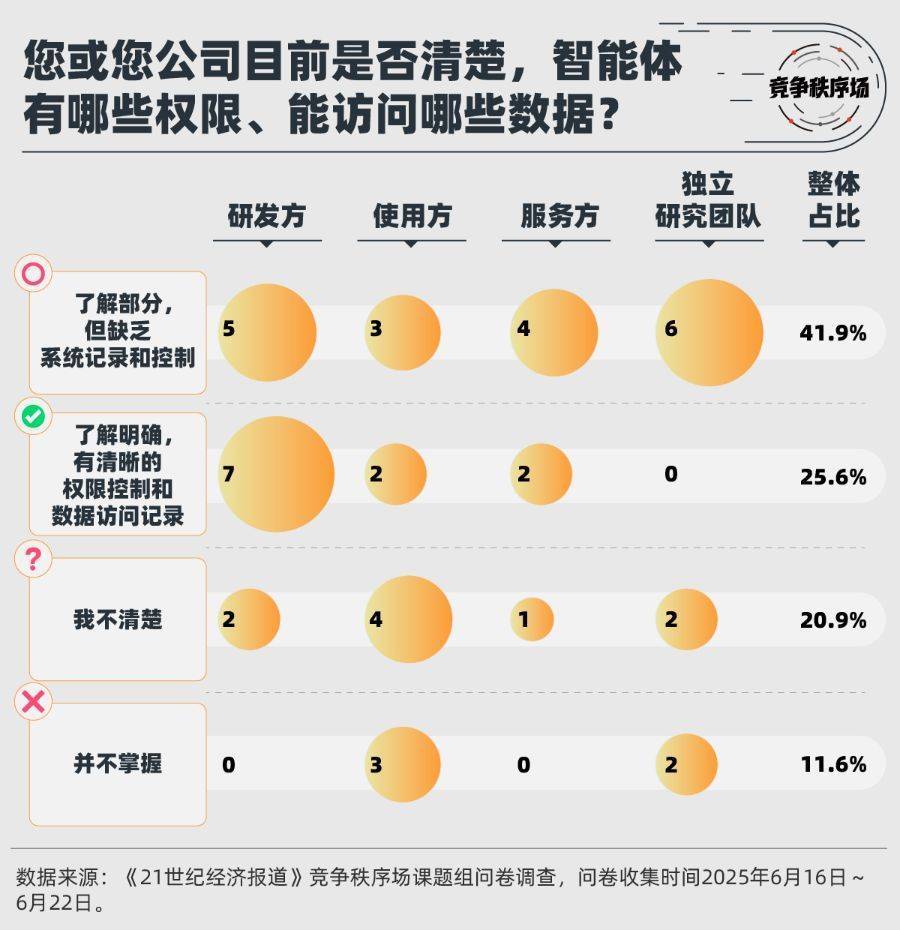

具体到公司如何应对安全问题上,尽管接近一半的人认为(48.8%),智能体安全合规问题在公司内的优先级非常高,与智能体性能、业务场景等同样重要——尤其是在使用方中。但调查结果显示,一半以上的使用方并不实际掌握/或者并不清楚智能体有哪些权限、能访问哪些数据(58%)。

明确了解智能体权限控制和数据记录的受访者,大部分为研发方。

有超过一半的受访者表示,公司尚无明确的智能体安全负责人或者自己不知道(51%)。有明确负责人的情况中,只有3%的人表示由单独的智能体安全合规团队负责,最常见的人员安排是智能体研发团队兼管安全问题(16.2%)。

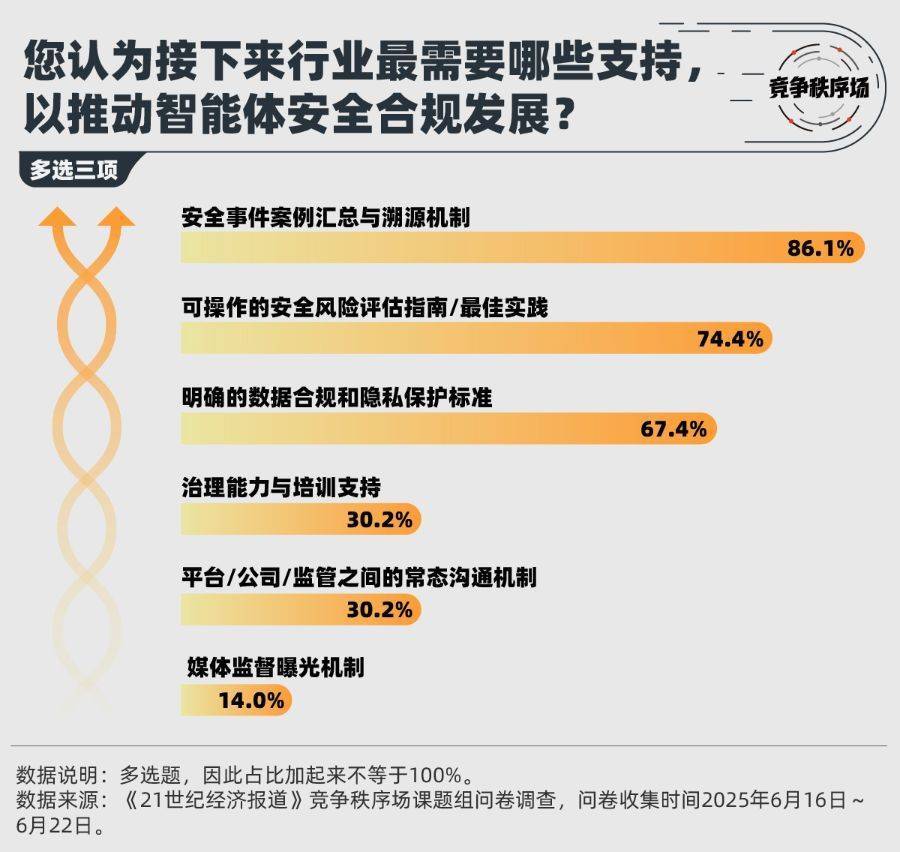

也因此,超过一半的受访者表示,安全事件案例汇总与溯源机制、可操作的最佳实践、明确的数据合规和隐私保护标准,是他们认为接下来最需要的安全合规支持。

更多内容请下载21财经APP沈阳配资平台

嘉喜网提示:文章来自网络,不代表本站观点。